|

Опрос

|

реклама

Быстрый переход

Google так и не решила проблемы с расовой инклюзивностью у генератора изображений Gemini

18.05.2024 [11:33],

Павел Котов

В феврале Google приостановила работу основанного на искусственном интеллекте генератора изображений Gemini, который допускал оскорбляющие общественность исторические неточности. К примеру, расовое разнообразие солдат по запросу «римский легион» — явный анахронизм — и стереотипно чёрные мужчины по запросу «зулусские воины». Кажется, ничего не изменилось до сих пор.

Источник изображения: blog.google Гендиректору Google Сундару Пичаи (Sundar Pichai) пришлось принести извинения за сбой в работе генератора изображений Gemini, а глава ответственного за проект профильного подразделения Google DeepMind Демис Хассабис (Demis Hassabis) пообещал, что ошибка будет исправлена в «кратчайшие сроки» — за несколько недель. Сейчас уже середина мая, а ошибка до сих пор не исправлена. На этой неделе Google провела ежегодную конференцию I/O, на которой рассказала о множестве новых функций Gemini: модель ИИ сможет использоваться для создания собственных чат-ботов, планировки маршрутов, она будет интегрирована в Google Calendar, Keep и YouTube Music. Но генерация изображений до сих пор отключена в приложении Gemini и веб-интерфейсе, подтвердил ресурсу TechCrunch представитель Google. Причин задержки он не пояснил. По одной из версий, при обучении ИИ используются наборы данных, в которых превалируют изображения белых людей, тогда как представители других рас и этнических групп составляют исключения, что формирует стереотипы. В попытке исправить этот перекос Google могла прибегнуть к кардинальной мере — жёсткому кодированию, при котором данные встраиваются непосредственно в исходный код. Исправить созданный таким образом алгоритм очень непросто. ChatGPT научился напрямую загружать файлы из «Google Диска» и Microsoft OneDrive

18.05.2024 [10:21],

Николай Хижняк

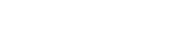

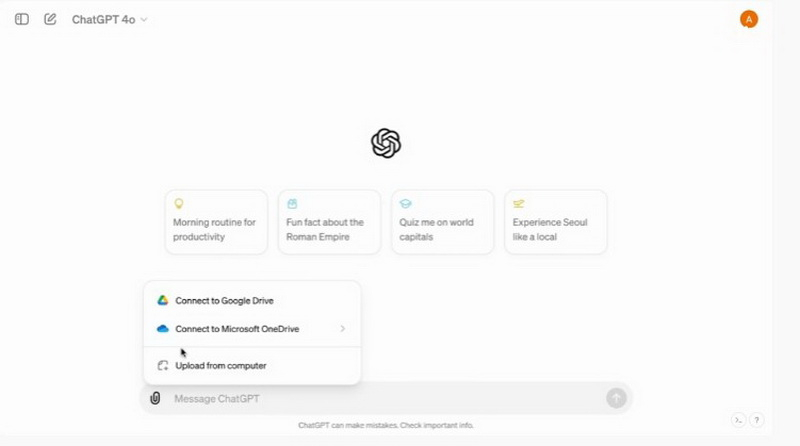

Компания OpenAI сообщила, чат-бот ChatGPT сможет загружать и анализировать данные с облачных хранилищ «Google Диск» и Microsoft OneDrive без необходимости их скачивания и последующей загрузки в чат-бот. OpenAI выпустит соответствующее обновление в ближайшие недели.

Источник изображений: OpenAI Функция загрузки данных для анализа из «Google Диска» и Microsoft OneDrive станет доступна пользователям платных подписок ChatGPT Plus, Enterprise и Teams. Для этого необходимо будет предоставить чат-боту доступ к учётной записи указанных облачных сервисов. Как объясняет OpenAI в своём блоге, за счёт новой функции чат-бот сможет быстрее просматривать и анализировать файлы Excel, Word, PowerPoint и их эквиваленты от Google. На данный момент функции анализа данных доступны только через GPT-4o — улучшенную версию GPT-4.  OpenAI также улучшила способность ChatGPT понимать информацию из инструкций, написанных на естественном языке. Пользователи могут попросить чат-бота проанализировать код на Python, объединить или очистить наборы данных, а также создать диаграмму на основе информации, содержащейся в том или ином файле.  ChatGPT и ранее мог создавать графики и таблицы по запросу, однако теперь он позволяет с ними взаимодействовать — расширять с помощью дополнительных ячеек, а также настраивать визуализацию данных с помощью цветов. Сейчас ChatGPT поддерживает визуализацию для гистограмм, линейных, круговых и точечных диаграмм. Для остальных, он будет создавать статичные версии этих элементов без возможности редактирования. В своём блоге OpenAI также напомнила, что не будет обучать свои ИИ-модели на основе данных, которые загружают пользователи ChatGPT Enterprise и Teams. Подписчики ChatGPT Plus, в свою очередь, могут отказаться от функции обучения. Google выпустил вторую бету Android 15 с «Личным пространством», предиктивным «Назад» и множеством других нововведений

18.05.2024 [00:05],

Анжелла Марина

Компания Google представила вторую бета-версию операционной системы Android 15. Обновление станет доступно не только для смартфонов серии Pixel, но и для устройств других производителей, включая Honor, OnePlus, iQOO, Lenovo, Nothing, Realme, Oppo, Tecno, Sharp, Vivo и Xiaomi.

Источник изображения (скриншот): 9to5google.com Одним из ключевых нововведений в Android 15 станет функция Private Space («Личное пространство»). Она позволит создавать на смартфоне отдельные зашифрованные профили для хранения личных файлов, фотографий, переписок и другой конфиденциальной информации. При блокировке личного профиля все связанные с ним приложения автоматически приостанавливают свою работу. Private Space будет иметь независимые настройки блокировки экрана. Пользователи смогут задать для него отдельный пароль или другой механизм защиты. Кроме того, личные приложения не будут отображаться на рабочем столе и в списке недавних приложений. Это защитит конфиденциальные данные от случайного доступа. Интересным нововведением стал предиктивный жест «Назад». Теперь при переходе между страницами приложения и выходе из него пользователь видит, куда именно его приведёт жест «Назад» и он будет знать, не закроет ли жест приложение. Во второй бете Android 15 новая функция активна по умолчанию. Но полноценно она работает лишь в приложениях, которые добавили её поддержку. В основном это сервисы Google и «Настройки». Ещё одно важное улучшение коснется производительности и энергосбережения. Android 15 не позволит приложениям активно работать в фоновом режиме более 6 часов. А это должно сократить ненужную загрузку процессора и сэкономить заряд батареи. Кроме того, Google обещает оптимизировать переходы между приложениями и режимами для более плавной работы. На больших экранах появится возможность закреплять панель недавних приложений. А для режима «картинка в картинке» реализуют улучшенную анимацию переходов. Изменился дизайн панели громкости, которая открывается по нажатию на три точки в мини-панели, вызываемой физической качелькой. Регуляторы громкости медиа, уведомлений, звонков и будильников теперь выполнены в фирменном стиле Material You, с толстыми ползунками. Ещё одна новая полезная опция связана с расширенными настройками вибрации для оповещений. Теперь пользователи смогут назначать уникальные тактильные сигналы для разных приложений и типов уведомлений. А обновленный модуль Google Health Connect получит поддержку дополнительных датчиков, в том числе для отслеживания температуры тела. Ещё пользователи теперь могут создать ярлык для пары приложений для их быстрого запуска в режиме разделённого экрана. А опция «Не рекомендовать» стала доступна по удержанию иконки приложения в списке рекомендованных. Таким образом, новая версия Android сосредоточится на повышении удобства использования, производительности и безопасности личных данных. Следующая бета-версия должна появиться в июне, финальная ожидается на месяц позже, а затем Google представит окончательный публичный релиз. Пока же производители устройств тестируют бета-версию на совместимость со своим программным обеспечением и «железом». Android 15 добавит смартфонам адаптивную вибрацию

17.05.2024 [12:36],

Павел Котов

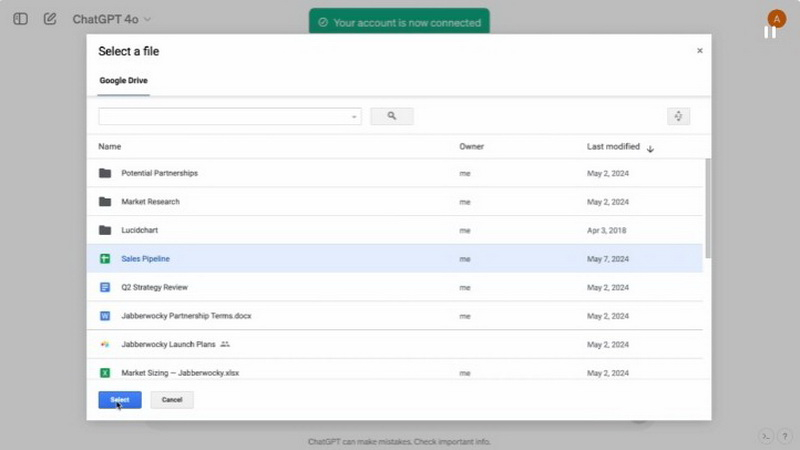

Google добавила в Android 15 Beta 2 настройку «Адаптивная вибрация» (Adaptive Vibration), при включении которой телефоны Pixel станут регулировать интенсивность работы вибромотора, анализируя поступающие с микрофонов и других сенсоров данные, обращает внимание 9to5Google. Ручная регулировка виброотклика появилась в Android уже давно, и теперь в Google решили развить эту идею.

Источник изображения: Adrien / unsplash.com По умолчанию настройка «Адаптивная вибрация» неактивна — по словам Google, с её включением телефон будет регулировать интенсивность вибрации в зависимости от окружения, получая данные от микрофона и других датчиков на устройстве. Подчёркивается, что собранная таким образом информация не записывается. «Адаптивная вибрация», например, уменьшает мощность виброотклика, когда телефон лежит на столе, но если он окажется на мягкой мебели, вибрация усилится.

Источник изображения: 9to5google.com Новая функция не связана с настройкой «Адаптивная вибрация оповещения» (Adaptive alert vibration), которая снижает интенсивность виброотклика, когда телефон обращён экраном вверх, и когда экран включён. Эта функция дебютировала с Pixel 7a. Время покажет, как новая настройка проявит себя в реальной жизни, но по описанию она представляется полезной. Она присутствовала и в предыдущих бета-версиях системы, утверждает Android Authority, но теперь ей можно воспользоваться на практике, хотя по умолчанию она ещё отключена. Wear OS 5 существенно увеличит время автономной работы смарт-часов

16.05.2024 [12:55],

Владимир Фетисов

В этом году Google выпустит Wear OS 5, новую версию своей программной платформы для смарт-часов. Она получит ряд улучшений по сравнению с предыдущей версией операционной системы, а также обеспечит лучшую автономность мобильных устройств.

Смарт-часы Pixel Watch 2 / Источник изображения: Google Одним из ключевых нововведений станет существенное увеличение времени автономной работы устройств. К примеру, устройства с Wear OS 5 будут на 20 % медленнее расходовать заряд аккумулятора во время длительных пробежек. Google продолжает делать акцент на увеличении времени автономной работы не просто так. Прошлогодняя Wear OS 4 позволила смарт-часам Pixel Watch 2 работать без подзарядки в течение всего дня, чего оригинальная версия устройства делать не могла. Очевидно, что очередная оптимизация энергоэффективности позволит устройствам работать без подзарядки ещё дольше. По данным Google, пользовательская база Wear OS за последний год выросла на 40 % и охватила 160 стран мира. Вероятно, оценить реальные улучшения в Wear OS 5 можно будет лишь позднее в этом году, когда на рынке появятся смарт-часы следующего поколения от Samsung и Pixel Watch 3. Обычно новые версии ОС появляются первыми именно на устройствах Samsung и собственных часах Google, тогда как сторонние разработчики выпускают продукты на её основе позднее.

Источник изображения: Google Помимо повышения автономности Google упоминает некоторые улучшения циферблатов для смарт-часов. Пользователи получат доступ к новым виджетам для просмотра данных о погоде, прогрессе в достижении целей и др. В дополнение к этому Google стремится облегчить разработчикам процесс создания интерфейсов для смарт-часов с большим круглым экраном. Также упоминаются инструменты, облегчающие процесс тестирования фитнесс-функций. Некоторые изменения получат функции для отслеживания состояния здоровья пользователя, такие как, например, возможность просмотра данных за последние 30 дней. Ряд улучшений ждёт и фитнес-функции, например, появление возможности сбора большего количества данных во время занятий бегом. Несмотря на то, что Google продолжает активно развивать платформу, похоже, что фрагментация Wear OS продолжит сохраняться. В прошлом году релиз Wear OS 4 состоялся до того, как Wear OS 3 стала доступна пользователям всех совместимых устройств сторонних разработчиков. Судя по всему, аналогичная ситуация повторится в этом году, когда начнётся распространение Wear OS 5. Поисковая выдача в чистом виде: в Google появился традиционный веб-поиск

16.05.2024 [11:48],

Павел Котов

В поисковой выдаче Google появилась вкладка «Веб-версия» (Web), которая показывает только традиционные текстовые результаты поиска без добавленных компанией многочисленных надстроек, загромождающих стандартные «десять синих ссылок».  Google добавила к вариантам поисковой выдачи опцию «Веб-версия», которая доступна наряду с привычными вариантами «Новости», «Изображения» и «Покупки». Потребность в этой опции возникла после многочисленных нововведений, которыми компания обогатила результаты поиска в последние годы — в новой вкладке показывается только текстовая выдача без изображений, предложений купить товары, карт и прочих элементов, которые Google считает полезными. Чтобы вернуть актуальный вид выдачи, придётся выбрать вкладку «Все» — она ведёт на страницу с дополнительными элементами, которые компания добавила как для удобства пользователей, так и для своей выгоды. Разница станет ещё заметнее после того, как Google доверит формирование страницы с результатами поиска искусственному интеллекту Gemini. На все эти дополнения жалуются и пользователи, которым не всегда удаётся пробраться сквозь дополнительные элементы к органическим результатам поиска, и владельцы сайтов, которые по той же причине получают меньше трафика. Ситуация осложняется проблемой поискового мусора: бесполезных ресурсов с чрезмерной поисковой оптимизацией, сайтов в большим объёмом сгенерированных ИИ текстов и поддельных интернет-магазинов, которые выманивают личные данные посетителей. Новый вариант с «чистым» веб-поиском станет доступен для пользователей по всему миру в ближайшие два дня. Он позволит людям изучать органическую выдачу и избавит от потребности открывать другие поисковые системы, чтобы свериться с их результатами. Правда, в Google пока не уверены в собственном нововведении: пункт «Веб-версия» скрыт в выпадающем меню «Ещё». Google выпустила Android TV 14 после двухлетнего перерыва — с ИИ Gemini и другими нововведениями

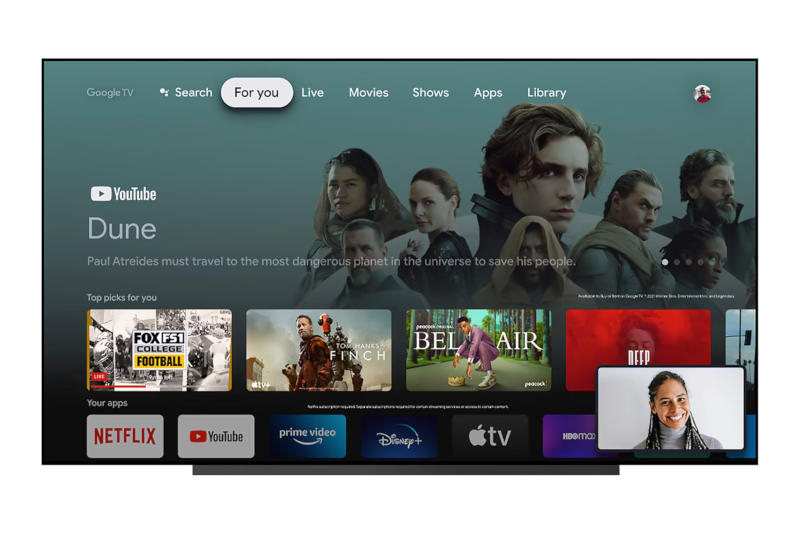

16.05.2024 [11:23],

Павел Котов

Впервые за два года Google выпустила крупное обновление ОС для умных телевизоров. После Android TV 12 вышла сразу Android TV 14: в прошлом году должна была выйти Android TV 13, но разработчик отказался от этой идеи и вместо стабильной новой версии платформы выпустил первую бета-версию Android TV 14.

Источник изображения: Google В Android TV 14 появились три режима потребления энергии. В большинстве случаев актуальным будет «Оптимизированный» (Optimized) режим, который позволяет выводить телевизор из режима ожидания при помощи голосового помощника или сетевой трансляции. «Режим пониженного энергопотребления» (Low energy mode) отключает все сетевые функции за исключением критических, когда телевизор находится в режиме ожидания. А «Режим повышенного энергопотребления» (Increased energy mode) позволяет даже в режиме ожидания поддерживать подключения Google Home, «Google Ассистента» и Cast. Добавлены некоторые настройки специальных возможностей: коррекция цвета, расширенные параметры текста и альтернативные параметры навигации. Google не привела подробностей, как работают эти функции, но уточнила, что их можно быстро включать и выключать при помощи ярлыков. Оптимизирована функция «картинка в картинке» — разработчики могут включать её поддержку для своих приложений. В обновлённом варианте она должна была дебютировать в Android TV 13, хотя технически её поддерживают все телевизоры, начиная с Android 7 (2016). Разработчики пренебрегали этой функцией, потому что средний умный телевизор недостаточно производителен для её работы. В новой реализации она работает только на «квалифицированных» моделях, так что популярность функции среди разработчиков теперь может вырасти. «Картинка в картинке» окажется полезной для приложений потоковых служб, видеоконференций и клиентов умного дома. К примеру, можно подать в угол телевизора трансляцию с камер видеонаблюдения. В новой реализации функции есть API «сохранения разборчивости», благодаря которому наложение одной картинки на другую не будет загораживать важного контента. Появилась интеграция искусственного интеллекта Gemini. Он предложит «персонализированные» описания фильмов и сериалов на главном экране Android TV — вероятно, это означает упоминание лент или артистов, которые нравятся пользователю. ИИ также заполнит недостающие или непереведенные описания, и это намного полезнее. Кардинальных изменений в дизайне Android TV 14 не отмечается, но Google выпустила бета-версию инструмента для разработки Compose for TV, ранее доступного в альфа-версии. Он включает набор предварительно настроенных модулей, которые ускорят разработку приложений и обеспечат единообразие интерфейса в приложениях Android TV. Первые телевизоры на Android TV 14 выйдут в этом году. К сожалению, с софтом для телевизоров дела обстоят хуже, чем с ПО для телефонов: производители редко выпускают крупные обновления для ТВ-устройств, и существующие модели под Android TV 12, вероятно, так и не получат Android TV 14. В Android появится ИИ-защита от кражи — смартфон заблокируется, если его кто-то схватит и убежит

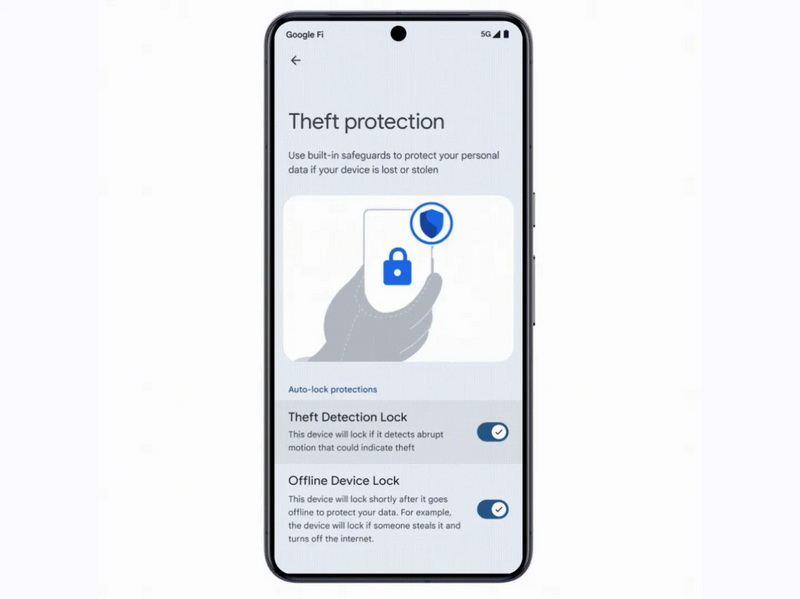

15.05.2024 [21:57],

Николай Хижняк

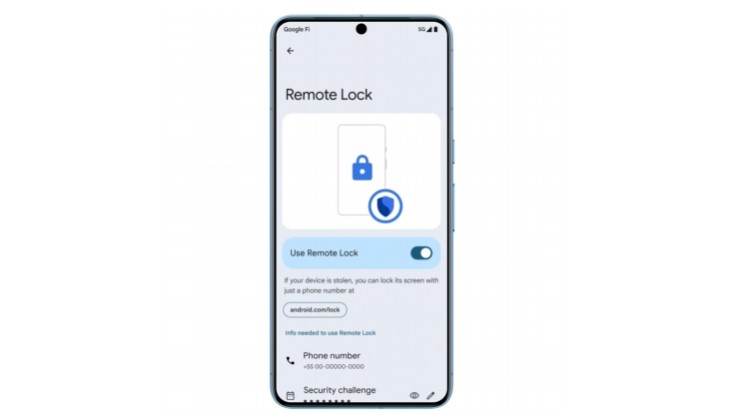

Компания Google выпустила вторую бета-версию своей будущей операционной системы Android 15, в которой реализовала ряд новых функций безопасности. Одна из них, например, позволяет определить момент, когда ваш телефон кто-то крадёт или выхватывает из рук, после чего устройство автоматически блокируется.

Источник изображений: Google Некоторые новые функции безопасности Android 15 также в перспективе появятся и в составе более старых версий операционной системы Android, что сделает их доступными для гораздо большего количества пользователей.  Новая функция Theft Detection Lock распознаёт необычные резкие движения мобильным устройством, которые могут указывать на то, что кто-то вырывает телефон из рук пользователя или хватает устройство со стола перед ним. Чтобы потенциальный злоумышленник не мог получить доступ к информации на устройстве, экран последнего автоматически блокируется. Система также следит за потенциальными попытками удалённого взлома устройства и автоматически отключает его от сети.  Google также предлагает новый способ удалённой блокировки экрана телефона, на тот случай если он попадёт в чужие руки. Для этого необходимо, например, с телефона друга, посетить сайт android.com/lock, где нужно ввести свой номер телефона и ответить на вопрос системы безопасности. После этого устройство будет заблокировано. Эти функции станут доступны с будущим обновлением сервисов Google Play для смартфонов под управлением Android 10 и более поздних версий. В Android 15 также представлена новая функция безопасности «Личные пространства», которая позволяет размещать приложения и данные в отдельной скрытой области памяти смартфона, которую можно заблокировать с помощью уникального PIN-кода. Google также добавила защиту от принудительной перезагрузки устройства и сброса на заводские настройки. В этом случае система запросит учётные данные владельца смартфона при следующей настройке. Функция Android Play Protect также получила обновление. Она проверяет, как приложения используют запрошенные разрешения на устройстве, чтобы отслеживать признаки фишинга и мошенничества. Информация о потенциально вредоносных приложениях отправляется в Google для дальнейшей проверки. Релиз Android 15 ожидается этой осенью. Google разберётся с OpenAI за использование YouTube для обучения ИИ

15.05.2024 [18:11],

Сергей Сурабекянц

Генеральный директор Google Сундар Пичаи (Sundar Pichai) пообещал «разобраться», если выяснится, что OpenAI использовала контент YouTube при обучении модели искусственного интеллекта, которая может генерировать видео. Он сообщил, что Google располагает всеми необходимыми инструментами и технологиями, чтобы выяснить, соблюдает ли OpenAI правила. По информации газеты New York Times, OpenAI при обучении моделей ИИ использовала более миллиона часов видео с YouTube.

Источник изображения: Pixabay «Послушайте, я думаю, что это вопрос, на который они должны ответить, — заявил Пичаи в интервью CNBC, когда его спросили, может ли компания подать в суд. — Мне нечего добавить. У нас есть чёткие условия обслуживания. Мы взаимодействуем с компаниями и следим за тем, чтобы они следовали нашим условиям обслуживания. И мы во всем разберёмся». В марте представитель OpenAI Мира Мурати (Mira Murati) в интервью Wall Street Journal сообщила, что она не уверена, являются ли видеоролики YouTube частью обучающих данных для модели ИИ Sora, представленной OpenAI ранее в этом году. По мнению Мурати, OpenAI опиралась на «общедоступные и лицензированные данные». Позже газета New York Times, ссылаясь на достоверные источники, утверждала, что OpenAI «записала более миллиона часов видео с YouTube». Пичаи дал интервью сразу после основного доклада на конференции Google I/O, где компания анонсировала новые модели генеративного ИИ, в том числе Veo, способную создавать полноценные видеоролики. Пока эта модель доступна только пользователям, получившим одобрение от Google. Пичаи также анонсировал мультимодальный ИИ-помощник Project Astra, который должен появятся в нейросети Google Gemini позднее в этом году. По словам Пичаи, Google сократила стоимость обслуживания моделей ИИ при веб-поиске на 80 %, используя собственные тензорные процессоры (TPU) и ускорители ИИ Nvidia. В ближайшее время компания начнёт отображать сводки ИИ в результатах поиска для всех пользователей в США. «У нас есть чёткое представление о том, как к этому подойти, и мы сделаем все правильно», — заявил Пичаи. В марте стало известно, что Apple обсуждает идею использования модели ИИ Gemini в iPhone. По словам Пичаи, Google на протяжении многих лет поддерживает «прекрасное партнёрство с Apple». «Мы сосредоточились на предоставлении отличных возможностей для экосистемы Apple, — заявил он. — И поэтому мы продолжим работать над воплощением ИИ-технологий в жизнь». Сотрудничество с Apple настолько важно для Google, что поисковый гигант отдаёт Apple 36 % доходов от контекстной рекламы в браузере Safari.

Источник изображения: Getty Images OpenAI на один день опередила мероприятие Google. Компания представила модель искусственного интеллекта под названием GPT-4o и показала, как пользователи мобильного приложения ChatGPT могут в формате естественного диалога общаться с ИИ-помощником, который «на лету» анализирует объекты, снимаемые камерой смартфона. OpenAI сообщила, что подписчики ChatGPT с тарифным планом Plus смогут опробовать предварительную версию нового голосового режима «в ближайшие недели». Google показала прямо в рекламном ролике, как ИИ даёт вредный совет

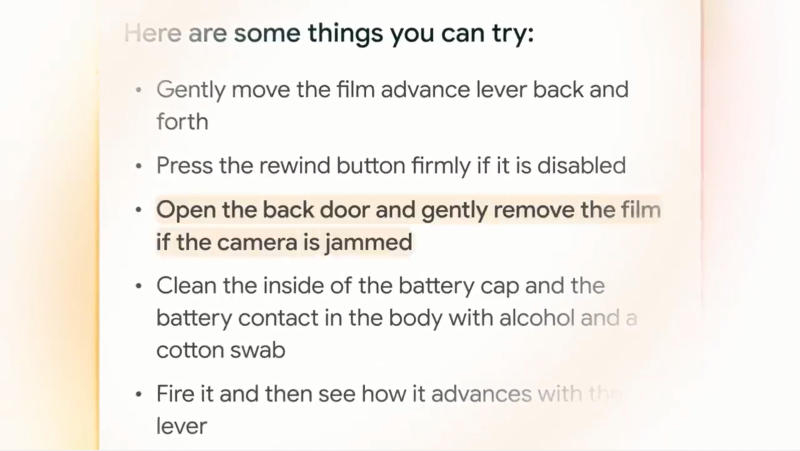

15.05.2024 [17:48],

Павел Котов

На конференции I/O 2024 компания Google подчеркнула, что разработанный ей нейросети Gemini станут новым словом в поиске и ИИ-ассистентах. Однако одна из самых ярких демонстраций возможностей этой системы снова омрачилась недостатком, присущим всем современным большим языковым моделям — галлюцинациями, то есть дачей заведомо неверного ответа.

Источник изображений: youtube.com/@Google В ролике «Поиск в эпоху Gemini» Google продемонстрировала видеопоиск — функцию поиска информации на основе видео. В качестве одного из примеров компания привела ролик с застрявшим рычажком перемотки плёнки на фотоаппарате и вопросом, почему этот рычажок не движется до конца. Gemini распознал видео, понял запрос и дал несколько советов по исправлению. И как минимум один из них оказался неверным.  ИИ порекомендовал «открыть заднюю крышку и аккуратно снять плёнку». И это, возможно, худшее, что можно сделать в данной ситуации. Потому что если открыть заднюю крышку плёночного фотоаппарата не в абсолютно тёмной комнате, плёнка засветится, и все сделанные снимки придут в негодность. Но на видео этот ответ подсвечен как наиболее подходящий. Google уже не впервые публикует рекламный материал с фактической ошибкой — заведомо неверной информацией, которую даёт ИИ. В прошлом году чат-бот Bard сообщил, что первый снимок экзопланеты — планеты за пределами Солнечной системы — был получен космическими телескопом «Джеймс Уэбб» (JWST), хотя это не так. Приложения на Android скоро позволят использовать лицо для управления курсором

15.05.2024 [12:18],

Владимир Фетисов

На этой неделе Google объявила, что код проекта Project Gameface стал доступен разработчикам приложений для программной платформы Android. Это означает, что разработчики смогут интегрировать в свои продукты функцию управления курсором с помощью мимики лица и движений головы.

Источник изображения: Solen Feyissa/unsplash.com Project Gameface был впервые представлен широкой публике на прошлогодней конференции Google I/O. Этот программный продукт использует камеру устройства для распознавания движений пользователя и сопоставления с базой данных MediaPipes’s Face Landmarks Detection API. К примеру, пользователь может открыть рот для перемещения курсора мыши или поднять брови вверх, чтобы выделить какую-то область экрана. «Через камеру устройства решение непрерывно отслеживает мимику и движения головы, преобразуя их в интуитивное и персонализированное управление. Разработчики теперь могут создавать приложения, в которых пользователи будут иметь возможность настройки, изменяя выражения лица, плавность жестов, скорость движения курсора и др.», — говорится в сообщении Google. Хотя изначально Gameface позиционировался как проект для геймеров, сейчас Google объявила о сотрудничестве с социальным фондом Incluzza из Индии, который занимается решением вопросов обеспечения доступности объектов и услуг различных сфер жизнедеятельности для людей с ограниченными возможностями. Ожидается, что такое сотрудничество поможет Google узнать больше о том, каким образом можно расширить возможности Gameface для использования его в других сферах, таких как работа, обучение и разные социальные ситуации. SEO отправят на пенсию: поисковую выдачу Google сформирует и дополнит генеративный ИИ

15.05.2024 [11:37],

Павел Котов

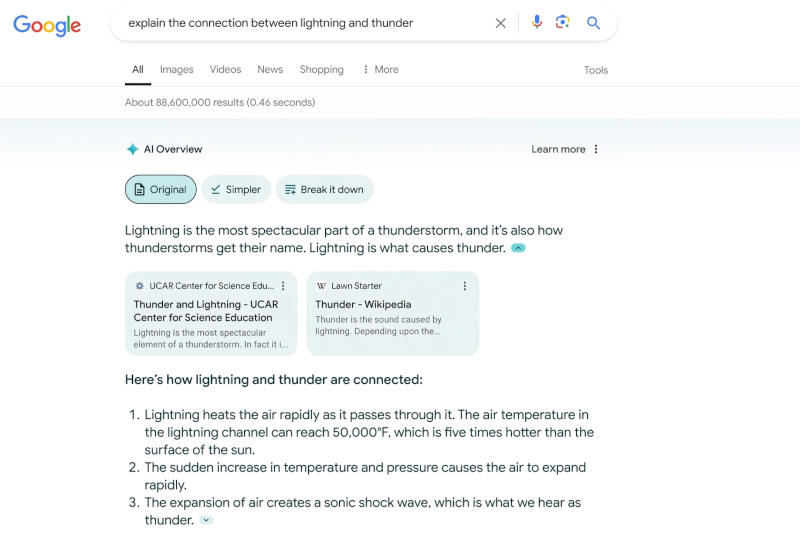

На конференции разработчиков Google I/O 2024 поисковый гигант объявил, что выдачу по некоторым запросам будет формировать генеративный искусственный интеллект. Её дополнит компонент AI Overview — блок со сводкой информации по поисковому запросу, ранее доступный участникам программы тестирования Google AI Labs. До конца года расширится присутствие формата Search Generative Experience (SGE) — его аудитория достигнет миллиарда пользователей.

Источник изображений: blog.google «Не думаем, что всё должно ограничиться сводками ИИ. Есть возможности для внедрения генеративного ИИ в поиск, и одна из областей, которая очень волнует лично меня — это формирование страницы результатов, организованной с помощью ИИ», — пояснила глава подразделения Google Search Элизабет Хармон Рид (Elizabeth Harmon Reid). Пока Google будет показывать страницу результатов поиска нового образца, если станет понятно, что пользователь ищет вдохновения. В приведённом на конференции примере это поездка на юбилей в другой город. Вскоре новый формат также будет подключаться при поиске заведений общепита, рецептов блюд, а за ними последуют кинематограф, книги, отели, покупки и многое другое. В случае с поездкой на юбилей в другой город придётся учесть разные аспекты: патио на крыше подойдёт не во всякое время года, а в качестве досуга можно полюбоваться архитектурой. При поиске ресторана Google покажет карусель с заведениями, продемонстрирует звёздный рейтинг, дополнит выдачу дискуссиями на Reddit и разбавит предложения дополнительной информацией: списками мест с живой музыкой, романтическими стейк-хаусами и материалами ресторанных критиков. А в нижней части страницы на демонстрации появилась кнопка «больше результатов из интернета» — возможно, это ссылка на страницу с традиционной выдачей.  Пока неясно, где на этих страницах будет размещаться реклама. И гендиректор Google Сундар Пичаи (Sundar Pichai) не дал прямого ответа, сохранится ли традиционная выдача при полномасштабном развёртывании инструментов ИИ. «Рад, что мы можем расширить спектр вариантов использования, в которых мы можем помочь пользователям поиска и Gemini. Перед вами примеры тех сложных вопросов, которые мы можем решить, как мы способны помочь в путешествии, интегрировать их с нашими продуктами и помочь более полно. Так что я рассматриваю это лишь с хорошей стороны», — пояснил глава компании. С прошлого года Google тестирует технологию ИИ-поиска SGE (Search Generative Experience). Поначалу её аудитория была крайне ограниченной, со временем она постепенно расширялась; уже на этой неделе SGE смогут пользоваться «сотни миллионов пользователей» из США, а к концу года размер аудитории достигнет миллиарда человек. В компании предупредили, что новый формат не вытеснит традиционного поиска, да и владельцам сайтов беспокоиться не стоит: при тестировании SGE пользователи переходили на внешние ресурсы ещё чаще, чем со страницы традиционной поисковой выдачи. Google не планирует тотального насаждения ИИ, считая его полезным в работе со сложными запросами и разрозненной информацией. Участвующий в поиске ИИ Gemini также окажется полезным в планировании. К примеру, если пользователь захочет составить программу питания семьи из четырёх человек на три дня, ИИ предложит ссылки на рецепты блюд. Gemini готов помочь в планировании и более масштабных мероприятий — поездок или вечеринок. Гуглить можно будет с помощью видео: Google Lens научат работать с видео и аудио

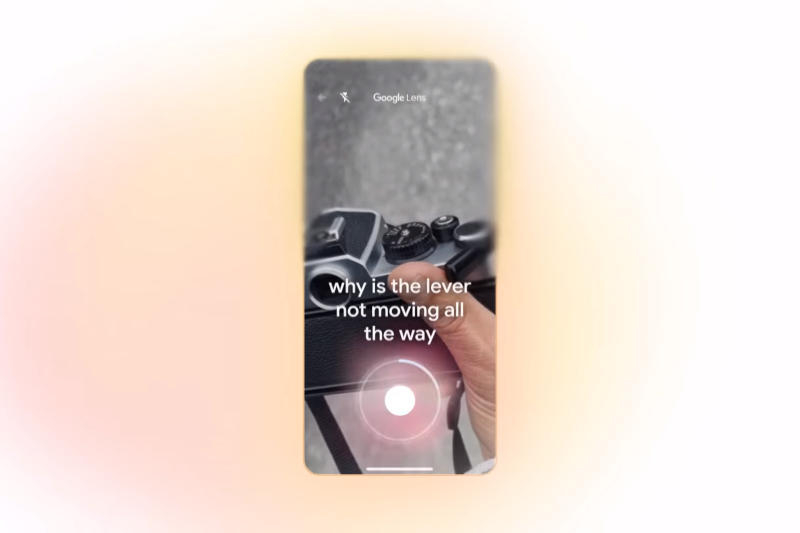

15.05.2024 [08:20],

Владимир Фетисов

Компания Google анонсировала скорое появление новой опции в своём инструменте визуального поиска Lens. Пользователи смогут осуществлять поиск в интернете по снятому видео. Прежде Google Lens мог обрабатывать запросы только со статическими изображениями, но уже скоро пользователи смогут записывать как видео, так и аудио, чтобы задать свой вопрос.

Источник изображения: Google Разработчики считают, что упомянутое нововведение может оказаться полезным во многих ситуациях, например, когда сломалось что-то в автомобиле или требуется получить дополнительную информацию о каком-то предмете, находящемся в поле зрения пользователя. Функция поиска информации по видео стала ещё одной точкой проникновения искусственного интеллекта в продукты Google. Мультимодальный поиск сейчас имеет важное значение для компании, а обработка видеозапросов относится именно к этой категории. Когда Lens распознаёт изображения, то пользователю приходится давать уточнения, что именно его интересует на том или ином снимке. В случае с видео пользователь может, например, навести камеру на какую-то деталь автомобиля и просто спросить, что это и зачем оно здесь нужно. У Google есть всё необходимое, чтобы обрабатывать и отвечать на такие вопросы. Сервис Lens является одним из ключевых элементов будущего поисковика Google из-за связи с инициативами компании в сфере искусственного интеллекта. Компания продолжает работать над созданием новых способов поиска информации в интернете, причём делает это не только чтобы пользователям было удобнее взаимодействовать с сервисом, но и для того, чтобы они делали это чаще. Касаемо Lens на данном этапе Google стремится сделать его менее похожим на компьютерный сервис и более похожим на всезнающего друга, которому всегда можно отправить видео с вопросом и получить ответ. Google показала Project Astra — ИИ-ассистента будущего, который видит и понимает всё вокруг

15.05.2024 [08:18],

Владимир Фетисов

Глава ИИ-подразделения Google DeepMind Демис Хассабис (Demis Hassabis) в рамках ежегодной конференции для разработчиков Google I/O рассказал о ранней версии того, что в компании называют универсальным ИИ-помощником. Речь идёт о системе под кодовым названием Project Astra, которая представляет собой мультимодальный ИИ-помощник, работающий в режиме онлайн. Он может «видеть» окружающее пространство, распознавать объекты и помогать в выполнении различных задач.

Источник изображения: Google «Я уже давно вынашивал эту идею. У нас будет этот универсальный помощник. Он мультимодальный, он всегда с вами<…> Этот помощник просто полезен. Вы привыкните к тому, что он всегда рядом, когда это нужно», — рассказал Хассабис во время презентации. Вместе с этим Google опубликовала небольшое видео, в котором демонстрируются некоторые возможности ранней версии Project Astra. Одна из сотрудниц лондонского офиса Google активирует ИИ-помощника и просит его сообщить, когда он «увидит» что-либо, способное издавать звуки. После этого она начинает поворачивать смартфон и когда в объектив камеры попадает стоящая на столе колонка, алгоритм сообщает об этом. Далее она просит описать стоящие на столе в стакане цветные мелки, на что алгоритм отвечает, что с их помощью можно создавать «красочные творения». Далее камера телефона направляется на часть монитора, на котором в это время выведен программный код. Девушка спрашивает ИИ-алгоритм, за что именно отвечает эта часть кода и Project Astra практически моментально даёт верный ответ. Далее ИИ-помощник определил местонахождение офиса Google по «увиденному» из окна пейзажу и выполнил ряд других задач. Всё это происходило практически в режиме онлайн и выглядело очень впечатляюще. По словам Хассабиса, Project Astra намного ближе предыдущих аналогичных продуктов к тому, как должен работать настоящий ИИ-помощник в режиме реального времени. Алгоритм построен на базе большой языковой модели Gemini 1.5 Pro, наиболее мощной нейросети Google на данный момент. Однако для повышения качества работы ИИ-помощника Google пришлось провести оптимизацию, чтобы повысить скорость обработки запросов и снизить время задержки при формировании ответов. По словам Хассабиса, последние шесть месяцев разработчики трудились именно над тем, чтобы ускорить работу алгоритма, в том числе за счёт оптимизации всей связанной с ним инфраструктуры. Ожидается, что в будущем Project Astra появится не только в смартфонах, но и в смарт-очках, оснащённых камерой. Поскольку на данном этапе речь идёт о ранней версии ИИ-помощника, точные сроки его запуска в массы озвучены не были. Google интегрирует искусственный интеллект Gemini в Gmail

15.05.2024 [04:25],

Анжелла Марина

На конференции Google I/O компания анонсировала интеграцию технологии искусственного интеллекта Gemini в почтовый сервис Gmail. ИИ сможет отвечать на вопросы пользователей, предлагать готовые ответы, а также выполнять рутинные задачи в фоновом режиме.

Источник изображения: Google Gmail является, пожалуй, самым популярным веб-интерфейсом для работы с электронной почтой в мире. Однако даже у такого удобного сервиса могут быть свои недостатки, связанные в первую очередь с тем, что работа с большим объёмом писем и вложений может быть весьма хаотичной и трудоёмкой. Для решения этой проблемы инженеры Google решили интегрировать в Gmail систему искусственного интеллекта Gemini. Система сможет анализировать содержание писем, извлекать из них ключевую информацию и даже формулировать варианты ответов. По словам вице-президента Google Апарны Паппу (Aparna Pappu), Gemini способен взять на себя всю «тяжёлую работу» по структурированию хаотичных потоков писем. Одна из ключевых особенностей ИИ заключается в возможности задавать вопросы непосредственно в цепочках писем. Например, пользователь может спросить у системы, какова была предложенная стоимость того или иного проекта, упомянутого в переписке. Gemini проанализирует соответствующие письма и выдаст точный ответ. Ещё одна полезная функция заключается в автоматическом сравнении конкурирующих коммерческих предложений от разных компаний и формирование из них сводных таблиц. Такие таблицы Gemini может генерировать самостоятельно на основе данных из писем. Помимо этого, искусственный интеллект избавит пользователей от необходимости вручную обрабатывать многочисленные входящие вложения к письмам, и займётся их организацией в облачном хранилище Google Drive, формируя из них также сводные таблицы. Это могут быть счета, чеки и другие вложения. Наконец, Google анонсировала интеграцию в Gmail персональных чат-ботов, которые смогут выполнять поиск информации и решать задачи по запросам пользователей в различных сервисах Google — таких как почта, облачное хранилище и других. По словам разработчиков, все эти новшества должны сделать работу с электронной почтой более эффективной и приятной, избавив от однообразных рутинных операций. Вместе с тем, интеграция Gemini в Gmail произойдёт не сразу. Сначала новые функции появятся в тестовом режиме Google Labs (этой осенью). А вот широкая публика сможет воспользоваться преимуществами ИИ в Gmail только в конце 2024 года или даже позже. При этом доступ к расширенным возможностям Gemini будет платным и составит $19,95 в месяц за каждого пользователя в рамках подписки Google AI Premium. |